El CERN no es extraño a la gestión de información por Internet, pero el novísimo LHC requerirá un tratamiento especial.

Escrito por Ian O'Neill

Ya sabemos que el Gran Colisionador de Hadrones (LHC por sus siglas en inglés Large Hadron Collider) será el experimento físico mayor y más caro jamás realizado por la humanidad. Colisionar partículas relativistas a energías antes inimaginables (hasta 14 TeV a finales de la década) generará millones de partículas (conocidas y sin descubrir todavía) de cuyo seguimiento y caracterización deberán encargarse enormes detectores de partículas. Este experimento histórico requerirá una esfuerzo masivo de recogida y almacenaje de información, reescribiendo las reglas del manejo de información. Cada cinco segundos, las colisiones del LHC generarán el equivalente a un DVD de información, o sea un ritmo de producción de datos de un gigabyte por segundo. Para verlo en perspectiva, un ordenador doméstico corriente con una conexión muy buena podría bajar datos a un ritmo de uno o dos megabytes por segundo (¡con mucha suerte! a mí me bajan a 500 kilobytes/segundo). De manera que los ingenieros del LHC han diseñado un nuevo tipo de método para manejar información que puede almacenar y distribuir petabytes (un millón de gigabytes) de información a los colaboradores del LHC de todo el mundo (sin que envejezcan ni les salgan canas mientras esperan que termine la descarga).

¿Un gigabyte por segundo? Ningún problema. La computación en red de LHC podría revolucionar la manera en que manejamos información por Internet (CERN).

Crédito de la imagen: CERN

En 1990, la Organización Europea para Investigación Nuclear (CERN) revolucionó la forma en que vivimos. El año anterior, Tim Berners-Lee, un físico del CERN, escribió una propuesta para la gestión de información electrónica. Adelantó la idea de que la información podría ser transferida fácilmente por Internet utilizando algo llamado "hipertexto". Con el tiempo, Berners-Lee y su colaborador Robert Cailliau, ingeniero de sistemas también del CERN, ensamblaron una única red de información para ayudar a que los científicos del CERN colaboraran y compartieran información desde sus ordenadores personales sin tener que guardarla en voluminosos dispositivos de almacenaje.

El hipertexto permitió a los usuarios navegar y compartir textos mediante páginas web utilizando hiperenlaces. A continuación, Berners-Lee creó un navegador-editor y pronto se dio cuenta de que esta nueva forma de comunicación podía ser compartida por una gran cantidad de personas. El CERN fue el responsable del primer sitio web del mundo: http://info.cern.ch/ y se puede ver un ejemplo del aspecto que tenía ese sitio en el sitio web del World Wide Web Consortium

De manera que el CERN no es extraño a la gestión de información por Internet, pero el novísimo LHC requerirá un tratamiento especial. Tal como pone de manifiesto David Bader, director ejecutivo de computación de alto rendimiento del Georgia Institute of Technology, el ancho de banda actual que permite Internet es un enorme cuello de botella, que hace más deseables otras formas de compartir información. "Si miro el LHC y lo que está haciendo para el futuro, la única cosa que la Web no ha podido hacer es gestionar una cantidad fenomenal de datos" declaró, en el sentido de que es más fácil grabar grandes bloques de información en discos duros de terabytes y enviarlos por correo a los colaboradores. Aunque el CERN previó la naturaleza colaborativa de compartir datos en la World Wide Web, la información que generará el LHC desbordará fácilmente los pequeños anchos de banda disponibles actualmente.

Cómo funciona el cómputo en red del LHC (CERN/Scientific American)

© Crédito imagen: CERN/Scientific American

(pulsar sobre la imagen para ampliarla)

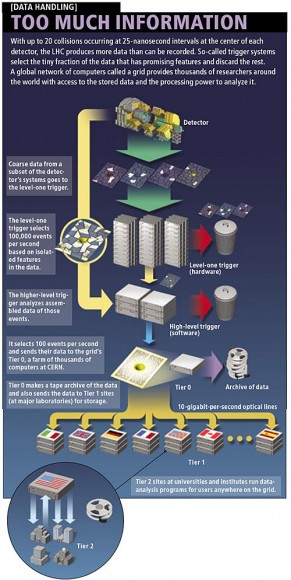

Ésta es la razón de que fuera diseñado el programa de Cómputo en Red del LHC. El programa gestiona la producción de vastos conjuntos de datos en niveles, el primero de los cuales (Nivel 0) está situado en las instalaciones del CERN cerca de Ginebra, en Suiza. El Nivel 0 consiste en una enorme red paralela de computación que contiene 100.000 CPUs avanzados que han sido preparados para almacenar y gestionar de inmediato los datos en bruto (1s y 0s del código binario) originados por el LHC. En este punto es preciso resaltar que los sensores no detectarán todas las colisiones de partículas, sino que sólo se puede capturar una fracción muy pequeña. Aunque sólo se pueda detectar un número comparativamente pequeño de partículas, sigue representando una cantidad ingente de información.

El Nivel 0 gestiona porciones de los datos obtenidos propulsándolos, mediante líneas específicas de fibra óptica de 10 gigabits-por-segundo, hacia 11 puntos de Nivel 1 situados en Norteamérica, Asia y Europa. Esto permite a colaboradores como el Relativistic Heavy Ion Collider (RHIC) del Brookhaven National Laboratory de Nueva York analizar datos del experimento ALICE, comparando los resultados de las colisiones de iones de plomo del LHC con sus propios resultados de colisiones de iones pesados.

Desde los ordenadores internacionales de Nivel 1, los bloques de datos son ensamblados y reenviados a 140 redes de ordenadores de Nivel 2 situadas en universidades, laboratorios y empresas privadas de todo el mundo. Es en este punto donde los científicos tendrán acceso a los bloques de datos para realizar la conversión desde el código binario bruto a información utilizable sobre energías y trayectorias de partículas.

El sistema de niveles está muy bien, pero no funcionaría sin un tipo de software altamente eficiente llamado "middleware" ("software intermedio"). Al intentar acceder a los datos, el usuario puede querer información que está repartida en los petabytes de datos de diferentes servidores en distintos formatos. Una plataforma de middleware de código abierto llamada Globus tendrá la enorme responsabilidad de reunir la información requerida en forma continua, como si esa información ya estuviera archivada en el ordenador del investigador.

Es esta combinación del sistema de niveles, conexión rápida y software ingenioso lo que podrá expandirse más allá del proyecto LHC. En un mundo en el que todo tiene que ser "inmediatamente", este tipo de tecnología podría hacer Internet transparente para el usuario final. Habría acceso instantáneo a todo, desde información producida por experimentos en el otro lado del mundo hasta visionar películas en alta definición si tener que esperar a que termine la descarga. De forma parecida al invento del HTML por parte de Berners-Lee, el cómputo en red del LHC podría revolucionar la manera en que utilizamos Internet.

Traducido del inglés para Astroseti.org por Marisa Raich

Enlace: http://www.universetoday.com/2008/09/04/the-lhc-will-revolutionize-physics-

Vía: Astroseti

Imagen actualizada por la USNO

Imagen actualizada por la USNO

0 comentarios:

Publicar un comentario

Todos los comentarios son responsabilidad únicamente de sus autores y no refleja necesariamente el punto de vista de este sitio.

NO insultes a nadie.